INTELLIGENZA ARTIFICIALE: OPPORTUNITÀ E IMPATTI SOCIALI, ETICI E DI GOVERNANCE

L'Editoriale di

N. Giugno 2019

a cura di Roberto Masiero

Presidente, The Innovation Group

Il 3 Ottobre 2019 si terrà a Milano “L’AI & DATA SUMMIT”.

Organizzato da The Innovation Group, sarà il punto d’incontro dell’intero ecosistema dell’Artificial Intelligence: Start-Up, Imprese, Industria ICT, Governo, Università, Centri di Ricerca italiani e internazionali. Questo articolo introduce uno dei temi del Summit: quello degli impatti sociali, etici, di policy e di governance dell’AI.

È convinzione diffusa che l’Artificial Intelligence sia destinata ad avere un impatto profondo sulla vita delle persone, sui modelli di Business delle imprese, sul funzionamento delle Pubbliche Amministrazioni, sulla crescita e la produttività dei sistemi economici.

Allo stesso tempo alcuni esprimono timori per una possibile minaccia ai valori fondamentali della nostra società. Certo, il risultato di processi di apprendimento endogeno sarà caratterizzato da incertezza e questo mette in crisi coloro che pensano ai processi della conoscenza come caratterizzati da una forma di deterministica razionalità.

Certo, Se non adotteremo misure adeguate potrebbero materializzarsi seri rischi per la tutela dei dati personali, la sicurezza delle persone, l’aggravamento delle disuguaglianze sociali ed economiche.

Ma questi legittimi timori non possono sconfinare nel catastrofismo dei tecnofobi; a cui si contrappone invece la visione di coloro che, come Marco Bentivogli[1], affermano che: “occorre un cambio di paradigma, di prospettiva e di senso; è necessario «anticipare, pensare e progettare la trasformazione», fare in modo che il nuovo che nasce compensi e superi ciò che muore”.

In questo contesto si colloca il recente Rapporto CEPS sull’Artificial Intelligence[2], redatto da una Task Force diretta da Andrea Renda.

Il Rapporto mostra una fotografia interessante dello stato dell’arte dell’Artificial Intelligence oggi in Europa e fornisce strumenti assai utili per una prima tassonomia di una materia che finora è stata interpretata soprattutto per silos disciplinari distinti.

La Task Force parte innanzitutto dalla seguente definizione di Intelligenza Artificiale:

“L’AI è uno Sviluppo di sistemi software (spesso anche utilizzati in combinazione con hardware) che, dato un obiettivo complesso, sono in grado di agire in modo da percepire l’ambiente che li circonda, acquisire e interpretare dati e formulare una decisione basata sui dati raccolti al fine di raggiungere l’obiettivo”.

In realtà l’AI è una famiglia di metodi e tecniche, alcune basate su istruzioni, altre basate su apprendimento, in cui il sistema osserva e acquisisce dati senza conoscere le regole del gioco e deduce queste ultime attraverso l’osservazione empirica: una maniera nuova che può lasciare molti di noi sconcertati perché siamo abituati ad affrontare la risoluzione dei problemi in maniera incrementale.

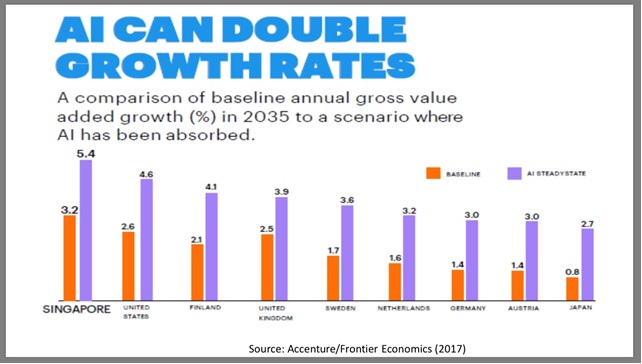

Il potenziale di crescita che l’AI può iniettare nei principali settori economici è enorme , come mostrano queste stime di Accenture/Economic Frontier .

Un potenziale enorme, che ha bisogno però di controllo e di direzione.

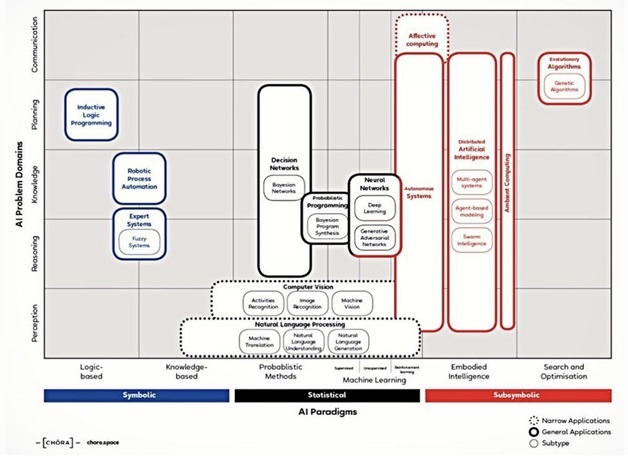

E per garantire le condizioni del controllo, è necessario avere una visione complessiva del mondo di “metodi e tecniche che costituiscono l’AI. È quindi particolarmente utile questa proposta di tassonomia, che il rapporto mutua da Francesco Corea (2018) [3]

In questa Mappa della conoscenza dell’AI si identificano alcuni paradigmi principali, che vengono classificati in tre approcci-macro:

- L’approccio simbolico, secondo cui l’intelligenza umana potrebbe essere ridotta alla semplice manipolazione di simboli

- L’approccio statistico, basato su tool matematici per risolvere sotto-problemi specifici

- L’approccio sub-simbolico, in cui nessuna specifica rappresentazione della conoscenza esiste a priori.

Le tecnologie sono divise in due gruppi, “narrow applications” e “general applications”. Senza pretendere di attingere all’ “Artificial General Intelligence”che rimane al momento una pura speculazione, la differenza fa riferimento da una parte a tecnologie che possono risolvere soltanto dei task specifici ( narrow applications), dall’altra a risolvere molteplici task e interagire col mondo meglio di molti esseri umani – oggi o nel prossimo futuro.

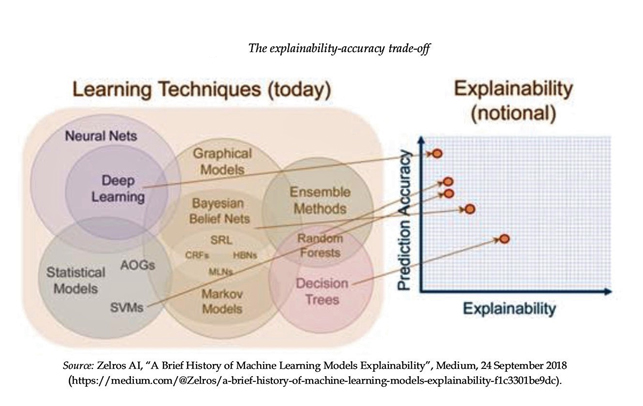

Certo l’Intelligenza Artificiale ha anch’essa i suoi dilemmi: il primo dei quali è dato dal trade-off tra “spiegabilità” e “accuratezza della predizione”, come descritto nel grafico seguente:

Particolarmente negli ultimi anni le tecniche delle reti neurali e di deep learning, che hanno dimostrato di riuscire a fornire i risultati migliori in termine di accuratezza delle previsioni, sono anche quelle meno spiegabili: nel senso che il loro funzionamento di base è facilmente comprensibile, mentre le decisioni che prendono non sono facilmente spiegabili all’utente finale, e in molti casi anche allo sviluppatore stesso.

In che misura siamo disposti a sacrificare la trasparenza delle decisioni in nome dell’accuratezza di questi sistemi?

Questo è un quesito che probabilmente ha soluzioni diverse in applicazioni e settori diversi. Ad esempio, nel settore industriale, dove l’efficienza e l’accuratezza del sistema sono prioritari, anche in considerazione della lontananza dall’utente finale, si tende a preferire sistemi meno spiegabili ma più accurati; mentre quando si tratta di spiegare a un soggetto perché un rene è andato a un altro paziente anziché a lui stesso, serve evidentemente un diverso livello di trasparenza.

Ci sono quindi diverse esigenze che devono essere considerate nel momento in cui si definiscono delle politiche pubbliche in questo campo.

Queste problematiche diventano ancor più scottanti nel momento in cui ci si chiede fino a che punto siamo disposti a utilizzare tecniche di Intelligenza Artificiale particolarmente invasive per garantire ad esempio di prevenire degli attentati o degli atti criminali (il cosiddetto “Minority report dilemma”).

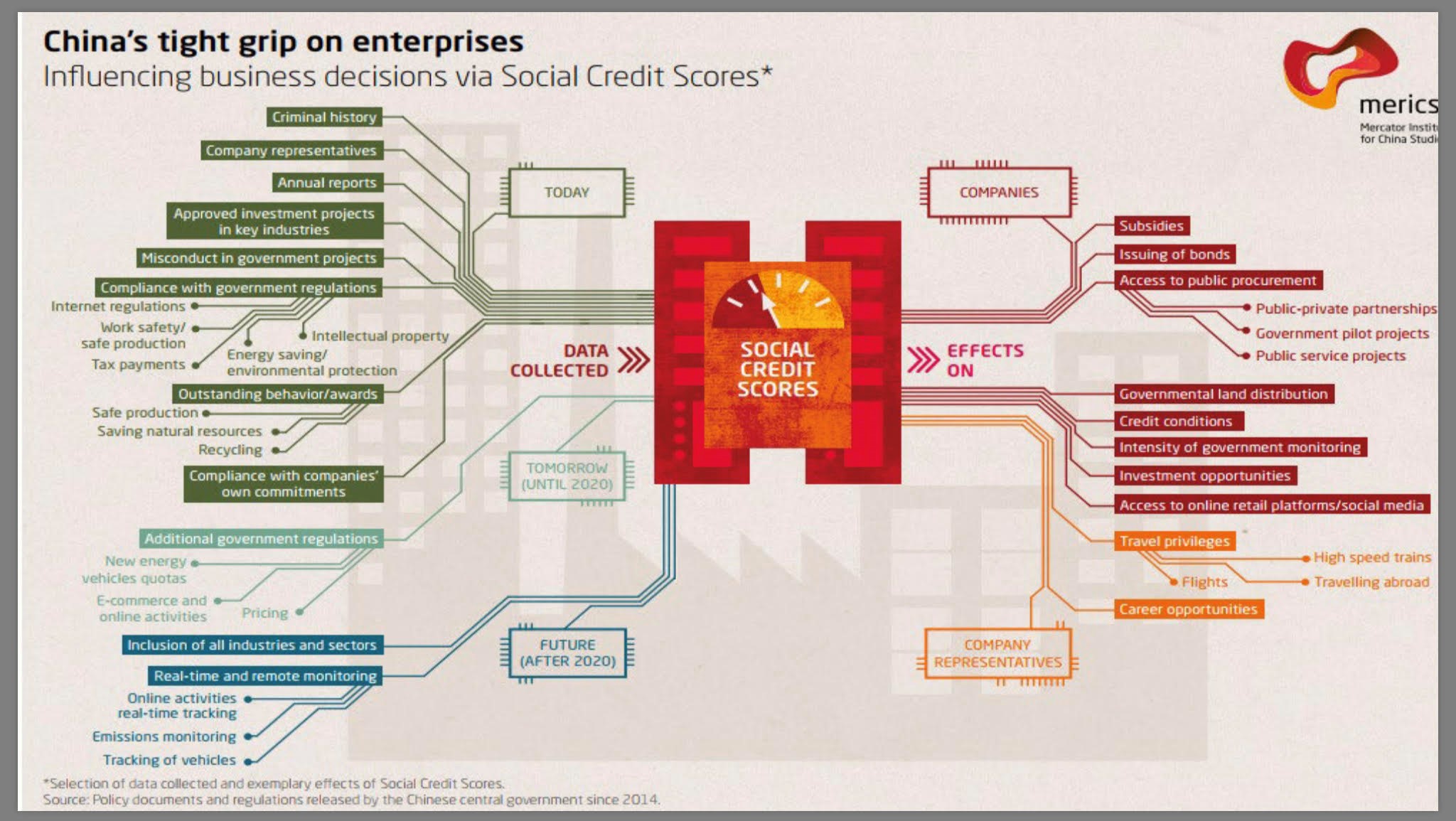

Partendo dalla diffusa richiesta di sicurezza, si rischia in questo modo di avviarsi verso un modello di società che non tutti sono disposti ad accettare, come nel caso del “Social Credit Scoring” cinese, illustrato nella figura seguente:

Una società perfettamente sicura, in cui a ciascuno viene attribuito un indice di affidabilità, che consente in caso positivo l’accesso a sussidi o servizi, e in caso negativo implica penalizzazioni che possono essere anche molto gravi.

[1] Marco Bentivogli, “Contrordine Compagni – Manuale di resistenza alla tecnofobia per la riscossa del lavoro e dell’Italia, Rizzoli 2019

[2] Artificial Intelligence – Ethics, governance and policy challenges – Report of a CEPS Task Force – a cura di Andrea Renda – 2019

[3] Francesco Corea, “AI Knowledge Map: How To Classify AI Technologies” Forbes, 22 Agosto 2018